در درس قبلی با بحثِ پس انتشارِ خطا آشنا شدیم و متوجه شدیم که شبکههای عصبی برای به هنگامسازیِ وزنها و انحراف، باید عملیاتِ پس انتشار را در هر بار اجرای الگوریتم انجام دهند. هر تکرار از اجرای الگوریتم که یک iteration شناخته میشود، میتواند وزن و انحرفها را به گونهای به هنگام (update) کند که الگوریتمِ شبکهی عصبی بتواند ویژگیهای مختلف و طبقههای متفاوت را شناسایی کند. برای درکِ بهتر فرض کنید خودتان در مدرسه برای امتحانِ نهایی آماده میشوید و میخواهید چند مرتبه از روی کتاب روخوانی کنید. در واقع شما هم به نوعی iterate را انجام میدهید.

در این درس به بحثِ کاهش گرادیان (gradient descent) در شبکههای عصبی میپردازیم که در واقع پایهی عملیات پس انتشار خطا میباشد.

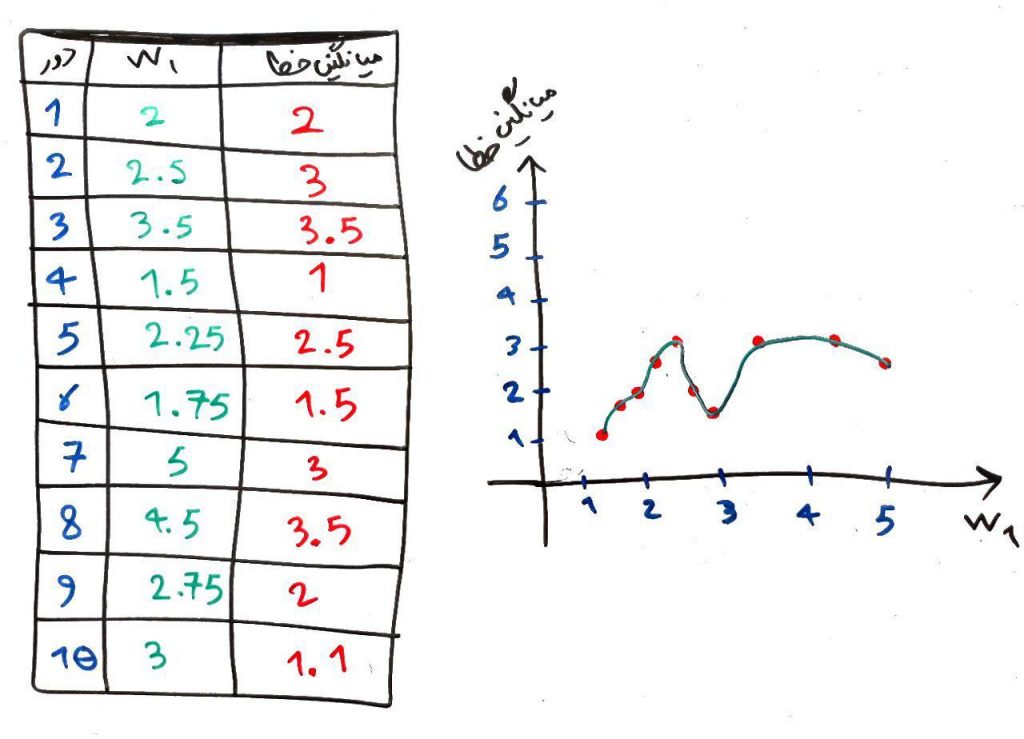

شکل زیر را از درس قبل به خاطر دارید:

گفتیم که در این مثال به دنبال کمترین مقدارِ خطا میگردیم. که با توجه به وزنها کمترین میزانِ خطا در وزن ۱.۵ رخ داده است که مقدارِ آن برابر ۱ است. یعنی ما با کم و زیاد کردنِ مقدارِ وزن میخواهیم کمترین میزانِ خطا را مشخص کنیم. اما در شبکههای عصبی (همانطور که بعداً خواهیم دید) تعداد بسیار بیشتری وزن خواهیم داشت که بایستی بههنگام (update) شوند. مثلاً در یک شبکهی عصبی برای پردازش تصویر ممکن است تا ۱۰۰۰ یا بیشتر وزن داشته باشیم که در این صورت باید تابعِ خطا را با توجه به هر ۱۰۰۰ وزنِ مختلف ارزیابی کرده و سپس هر کدام از این وزنها را تغییر داده و دوباره تست کنیم تا میزان خطا به دست آید. همانطور که تصور میکنید این عملیات بسیار وقتگیر و پرهزینه است. برای غلبه بر این مشکل از روشی به اسم کاهش گرادیان استفاده میشود که در این درس به آن میپردازیم.

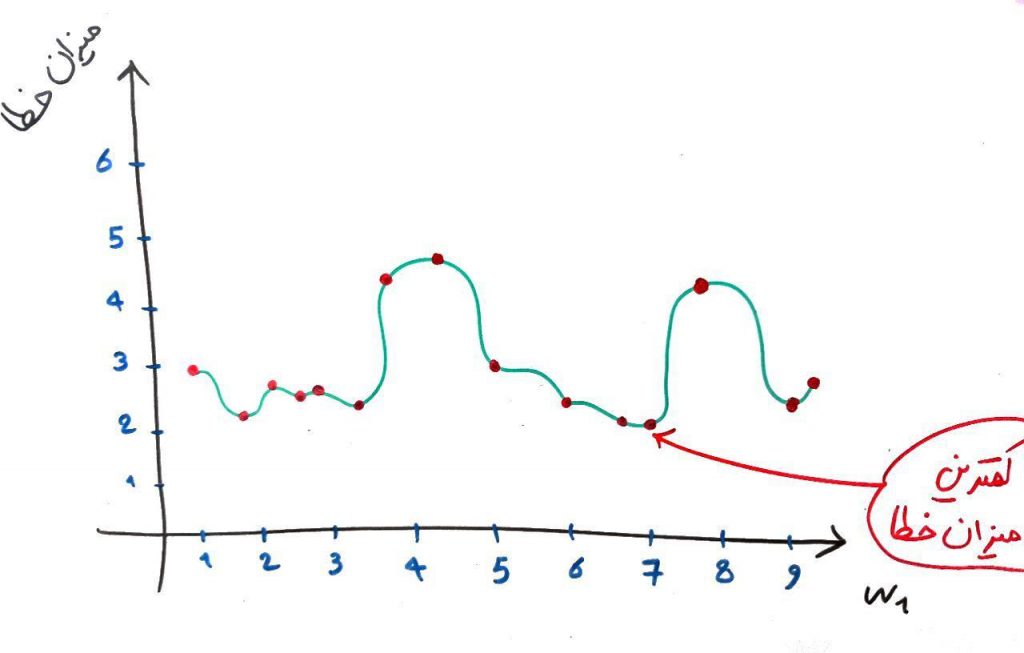

فرض کنید به جای مثال بالا، نمودار (که در واقع بیانگر خطاها در وزنهای مختلف است) مقادیرِ خطا برای وزن w1 به صورت زیر باشد:

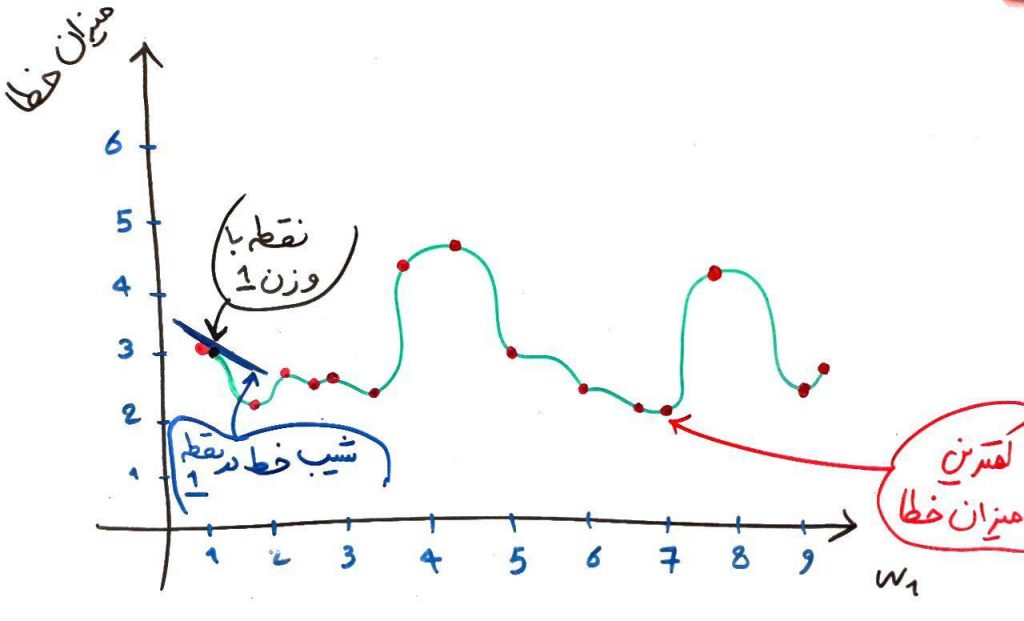

همان طور که مشاهده میکنید، کمترین میزان خطا در وزن ۷ اتفاق افتاده است. در روشِ کاهش گرادیان برای پیدا کردن این وزن از قوانین مشتق استفاده میشود. همانطور که میدانید مشتق، نشاندهندهی شیبِ خطِ مماس بر یک نقطه از یک تابع است. برای اینکه کمترین میزانِ خطا را به دست آوریم فرض میکنیم یک نقطهی دلخواه (یک وزن دلخواه) را در این تابع در نظر گرفتهایم. مثلاً نقطهی ۱ (یعنی وزن ۱). حال به تصویر زیر نگاه کنید:

در این نقطه مشتق که همان شیب خطِ مماس بر یک نقطه است یک عدد منفی بوده، چون خط به سمت پایین است. الگوریتمِ پس انتشار میداند که اگر شیبِ خط در یک نقطه (با توجه به وزنها) منفی بود بایستی مقدار آن وزن را افزایش دهد تا شیب خط به صفر برسد. شیب صفر یعنی کمترین میزان خطای ممکن در آن محدوده (برای درکِ بهتر، در همان تصویر بالا، شیب در محدودهی وزنِ ۱.۷۵ را نگاه کنید، یعنی جایی که خطِ سبز در کمترین میزانِ خود قرار دارد). همانطور که در شکلِ بالا مشخص است، کمترین میزانِ خطای ممکن در آن محدوده برای وزن ۱.۷۵ ثبت شده است که شیبِ خط در آنجا صفر است (موازی محور افقی است)، حال اگر کمی مقدار وزن را از ۱.۷۵ بیشتر کنیم شیب خط مثبت میشود، یعنی شیب به سمت بالا میرود. با مثبت بودنِ شیب خط، یعنی همان مشتق در آن نقطه، الگوریتمِ پس انتشار میفهمد که باید وزن را کم کند تا شیب به صفر برسد.

همان طور که در یک مثال بالا دیدید، الگوریتمِ پس انتشار میتواند با استفاده از این این تکنیک یک نقطهی کمینه برای خطا پیدا کند که البته کمترین مقدار در کل فضا نبود ولی به هر حال معقول به نظر میرسید. به این نقطهی معقول یک کمینهی محلی (local minimum) برای خطا میگویند. در شکل بالا وزن ۷ یک کمینهی سراسری، یعنی بهترین نقطه موجود در کل شکل (global minimum) است. البته رسیدن به این نقطهی سراسری برای الگوریتمِ پس انتشارِ خطا کار دشوار و زمانبری است.

برای همین معمولاً الگوریتم در شبکههای عصبی اینگونه آموزش میبیند که به تعداد تکرار مشخص یا تا رسیدن به یک خطای کمِ مشخص الگوریتم را ادامه بدهد و بعد از آن توقف کند. یعنی شبکه عصبی آنقدر تکرار را انجام میدهد تا به یک خطای معقول مشخصِ کم برسد . مثلاً در مثالِ بالا میگوییم اگر خطا زیر ۲/۵ شد دیگر کافی است. اگر این طور نشد یعنی خطا به اندازهی دلخواهِ ما کم نشده است و حالا میتوانیم برای تکرار محدودیت بگذاریم. مثلاً میگوییم تا ۱۰ هزار مرتبه تکرار را انجام بده (یعنی ۱۰ هزار مرتبه وزنها و انحراف را آپدیت کن) و بعد از آن دیگر یادگیری را ادامه نده.

حال که یادگیری انجام شد، شبکه دارای وزنها و انحرافِ مشخص است. از این به بعد شبکه میتواند یک سری ویژگی (مثلاً ویژگیهای یک پراید یا اتوبوس) را بگیرد و تشخیص دهد که این یک پراید است یا خیر. که البته همان طور که واضح است، این پیشبینی دارای خطایی نیز هست.

مثال بالا یک حالت بسیار بسیار ساده فقط با یک وزن بود. در شبکههای عصبی که وزنهای بسیار زیاد، تا ۱۰۰۰ یا بیشتر – با توجه به تعداد ویژگیها یا همان ابعاد، برای بههنگامسازی وجود دارد سرعتِ روش کاهش گرادیان به خوبی نمایان میشود چرا که روشِ پس انتشارِ خطا همراه با کاهشِ گرادیان میتواند بسیار سریع نقطهی کمینهی معقولی برای خطا را پیدا کند. البته که انواع مختلفی از روشهای کاهشِ گرادیان (یا همان صفر کردنِ مشتق) وجود دارد که در درسی جدا به آنها خواهیم پرداخت.

در شکل زیر هم در یک انیمیشن میتوانید ببینید که کاهش گرادیان چگونه در یک فضای ۲ بُعدی (با ۲ متغیر) کار میکند:

- ۱ » شبکه عصبی (Neural Network) چیست؟

- ۲ » تعریف پرسپترون (Perceptron) در شبکه های عصبی

- ۳ » پرسپترون در شبکه عصبی چگونه یاد میگیرد؟

- ۴ » پرسپترون چند لایه (Multi Layer Perceptron) چیست؟

- ۵ » درباره توابع فعال سازی پرسپترون و Sigmoid

- ۶ » تابع ضرر (Loss Function) در شبکه عصبی چیست و چه کاربردی دارد؟

- ۷ » نحوه یادگیری پس انتشار خطا (Back Propagation) در شبکه های عصبی

- ۸ » کاهش گرادیان (Gradient Descent) در شبکه های عصبی

- ۹ » حل یک مثال عددی یادگیری ماشین با شبکههای عصبی

از توضیحات مفید و راهگشای شما بسیار سپاسگزارم. امیدوارم در ادامه باز هم از مطالب مفیدتان بهره مند شویم.

سلام خیلی عالی بود اگه میشه واسه ی شی گرایی و ارث بری و اینجور چیزا هم ی دوره بزارین تا یاد بگیریم ی دنیا ممنون

شما بینظیرید. امیدوارم نتیجه به اشتراک گذاری علمتون به زبان ساده و روان را بگیرید.

سلام و وقت بخیر ممنون از توضیحاتتون. سوالی داشتم، اینکه در بالا جدولی رسم کردید که ۱۰ تا وزن با مقادیر متفاوت نوشته.

این مقادیر متفاوت رو کی بدست میاره؟ از کجا الگوریتم ۱۰ نو ع وزن متفاوت رو تست کرده ؟

آیا ده بار رندوم وزن دادیم و بعد بین ۱۰ بار کمترینو حساب کردیم؟

سلام، پاسخ به این سوال کمی پیچیدهتر هست ولی برای سادگی فرض کنید که الگوریتم چند بار به صورت تصادفی با وزنهای مختلف شروع شده است

خیلی ممنون مهندس . کاش راهی بود در راستای هدف این وب سایت بتونیم کمکی کنیم واقعا کارتون ارزشمنده . ادامه بدید لطفا

عالی بود … احسنت و سپاس

بسیار سپاسگزارم از توضیحات خوبتون

سلامت و سربلند باشید

سلام عالی بود

پیاده سازی شبکه عصبی توی سخت افزار و FPGA چطور ممکنه

مثلا بخام از روی صدا نوع اتوموبیل رو تشخیص بدم

یه پروژس

سلام لطفا همین آموزش رو به صورت فیلم توضیح بدید انتقال مفهوم بهتر میشه تشکر

آفرين ادامه بده

با سلام

این بهترین آموزش شبکه عصبی بود که تا الان دیده بودم

جناب کاویانی ان شا الله همیشه شاد و سلامت باشید

سپاس

جناب کاویانی آموزشهاتون بی نظیر و عالی است.ممنون از این همه زحماتی که برای آموزش دانش به دیگران میکشید.بسیار سپاسگزارم

سلام فوق العاده توضیح دادید

لطفا در مورد فرمول های ریاضیش بیشتر صحبت کنید

مثلا اگه بخوایم بدون کمک از جعبه ابزار های متلب یا هر زبان برنامه نویسی دیگه ای کدش رو بنویسیم

سلام واقعا دمت گرم…

عالی بود.

من نیاز به یک مرور مفید و جامع داشتم، هر هشت درس خیلی خوب و واضح بود.

خیلی خوب بود آموزش تون. سپاسگذارم

بسیار عالی و جامع بود

همه قسمتها رو تو یه ساعت خوندم و لذت بردم. مدت کمی هست که شروع به یاد گرفتن در مورد شبکه عصبی کردم. مطالب شما مثل یه معلم با حوصله منو راه انداخت

عالی بود سپاس از شما

واقعا ساده و خوب توضیح دادید سپاس